Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | |

| 7 | 8 | 9 | 10 | 11 | 12 | 13 |

| 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| 21 | 22 | 23 | 24 | 25 | 26 | 27 |

| 28 | 29 | 30 | 31 |

Tags

- 배치

- 라벨

- 손실함수

- 머신러닝

- 파일 열기

- tensor

- 컴퓨터비전

- 파이썬프레임워크

- dl

- propagation

- MSE

- PySide6

- GUI

- numpy

- 데이터셋

- 프레임워크

- Plot

- 그래프

- 컴공

- TXT

- pytorch

- channel

- 딥러닝

- 대학생

- Batch

- 파이썬

- matplotlib

- perceptron

- loss function

- 객체인식

Archives

- Today

- Total

Welcome to Jiyuniverse

Part 1. Introduction to Deep Neural Networks 본문

KAIST 주재걸 교수님의 딥러닝 강의를 듣고 필기한 내용입니다. 추후 정리 예정

- One kind of neural networks

- Input node, Weights → Output node

Single Layer Perceptron

- 활성함수 : Hard thresholding function

- 내적 + bias 값이 0 이상이면 1, 음수이면 0

- AND, OR, XOR Gate로 표현 가능

Decision Boundary in Perception

하나의 직선만으로 양수, 음수 구분 가능 (AND, OR)

But, It is not possible to solve a XOR problem using a single layer perceptron

→ Single layer perceptron can only solve linear problem. XOR problem is non-linear

XOR problem을 해결할 때에는 Multi-Layer Perceptron 사용 (Hidden layer)

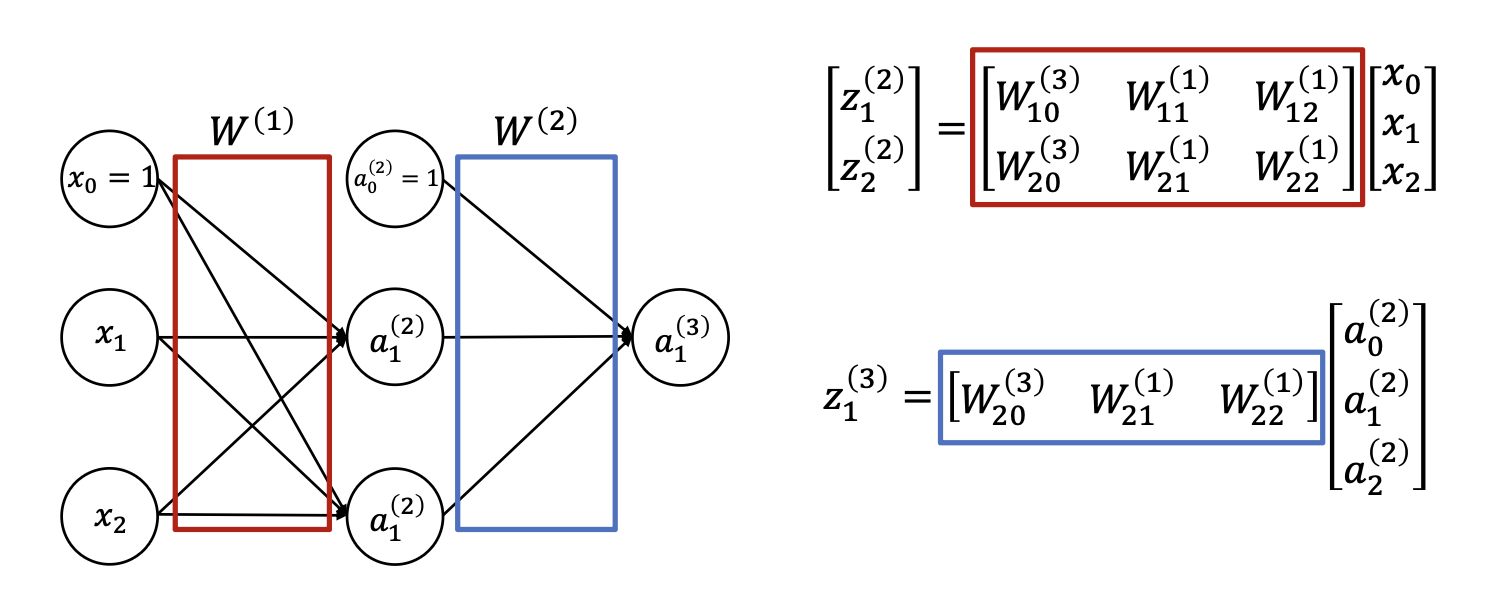

Forward Propagation

- 수학적으로 표현함

- 활성함수 : Sigmoid function

- 내적한 값을 활성함수 g(x)에 통과시키면 output node 값이 됨.

Linear Layer / Fully-connected Layer

- The layer where perceptrons are fully connected between two layers

Loss function

- MSE (Mean-Squared Error)

- Softmax Loss (or Cross-Entropy Loss)

- Logistic Regression (Binary Class, Softmax Classfier 사용) = BCE?